در زمینه ریاضیات نمی توان به مدل های بزرگ زبانی (LLM) به طور کامل اعتماد کرد. این مقاله توضیح می دهد که چرا مدل های زبان بزرگ در ریاضیات ضعیف هستند.

به گزارش TechNock، هنگام بررسی مدل های زبانی در مقیاس بزرگ (LLM)، ممکن است فکر کنید که آنها راه حلی جادویی برای اکثر مشکلات شما هستند. می توان از آنها برای برنامه ریزی روز خود یا پرسیدن سؤالات مختلف استفاده کرد، به این امید که به بهترین شکل ممکن به شما پاسخ دهند. با این حال، یک حوزه وجود دارد که نباید به LLM ها کاملاً اعتماد کرد: ریاضیات.

به طور خاص، در حالی که LLM ها می توانند الگوهای ریاضی را از داده های بزرگ بیاموزند و با اعداد کوچکتر به نتایج دقیق تری برسند، هنوز از محاسبات ماشین حساب کوتاهی می کنند. این ضعف آشکار در محاسبات ریاضی LLM ها قبلاً در تحقیقات و تحقیقات گزارش شده است مقالات مانند “GPT می تواند مسائل ریاضی را بدون ماشین حساب حل کند” بررسی شده است.

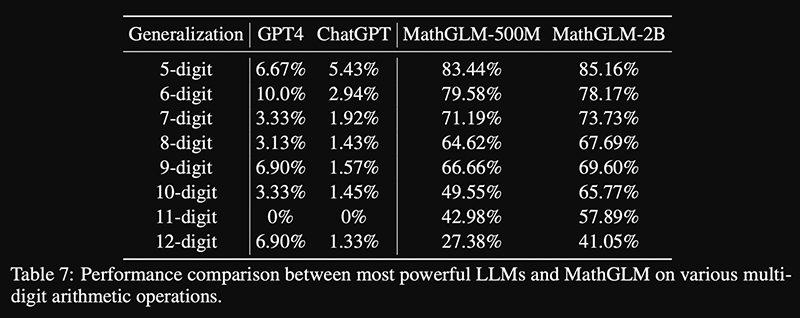

دانشگاه Tsinghua مدلی به نام MathGLM معرفی کرد که برای حل مسائل ریاضی آموزش دیده و دقت بالایی دارد. این مدل در مقایسه با GPT-4 و ChatGPT عملکرد بهتری دارد.

همانطور که از محاسبات بالا مشاهده می شود، MathGLM از GPT-4 و ChatGPT بهتر عمل می کند. با این حال، مشکل این است که حتی با محاسبات پنج رقمی، بهترین نتیجه ای که می توانید از مدلی با 2 میلیارد پارامتر بگیرید، دقت 85.16 درصد است. مهم نیست که 5×10000 همچنان 50000 است و اگر LLM به آن نزدیک شود. اما دقیقاً یکسان نیست، بنابراین پاسخ هنوز اشتباه است. ماشین حساب هر بار تمام این مشکلات را با دقت 100% حل می کند.

با افزایش اندازه عدد، دقت کاهش می یابد، که احتمالاً به دلیل تمرکز بر محاسبات کوچکتر در داده های آموزشی است. مدل ها در واقع محاسبات را انجام نمی دهند. بلکه در حال شناسایی الگوها هستند. برای استفاده از MathGLM می توانید به GitHub تیم را ببینید؛ اما اجرای آن نیاز به یک کامپیوتر قدرتمند دارد.

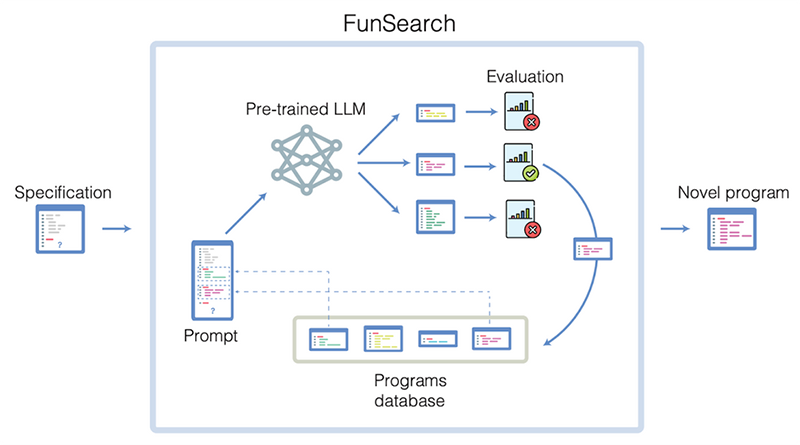

در مقابل، گوگل با FunSearch خود که یک LLM از پیش آموزش دیده را با یک ارزیاب خودکار ترکیب می کند تا خطاها را کاهش دهد، به موفقیت دست یافته است. این روش به LLM ها اجازه می دهد تا با حفظ خلاقیت از انحرافات بیش از حد اجتناب کنند. در حالی که LLM ها در ریاضیات ضعیف هستند، در تولید ایده های خلاقانه عالی هستند.

FunSearch یک رویکرد جدید از گوگل است که با استفاده از توضیح مسائل ریاضی در قالب کد کار می کند. این توصیفات به عنوان مبنایی برای ارزیابی خروجی ها و ایجاد مجموعه اولیه از برنامه ها عمل می کند. در هر تکرار، FunSearch برخی از برنامه ها را انتخاب می کند و آنها را به LLM، مانند PalM 2، برای ایجاد برنامه های جدید ارائه می دهد. بهترین ها برای بهبود مستمر انتخاب می شوند.

FunSearch در یافتن بزرگترین کلکسیون های کلاهی موفق بود و از بهترین های شناخته شده توسط برخی از دانشمندان برجسته جهان پیشی گرفت. طبق مقاله ای در نیچر، این ممکن است اولین کشف علمی باشد که توسط LLM به دست آمده است.

گوگل با FunSearch نشان داده است که LLM ها می توانند ابزار قدرتمندی برای ریاضیات باشند. اما نه تنها. با ترکیب خلاقیت LLM ها با ارزیاب های دقیق، می توان مشکلات پیچیده را حل کرد و ایده های نوآورانه تولید کرد. این نشان دهنده توانایی LLM در ریاضیات نیست. بلکه بیشتر مهارت مهندسان در هدایت آنها به سمت نتایج دقیق و معنادار است.

وقتی از یک مدل زبان بزرگ (LLM) مانند ChatGPT یا Bard میخواهید یک مفهوم ریاضی را توضیح دهد (مثلاً چگونه دو ماتریس را ضرب کنیم)، معمولاً میتوانید انتظار داشته باشید که توضیح دقیق و درستی دریافت کنید. این مدل ها در توصیف مفاهیم و فرآیندهای نظری ماهر هستند و می توانند اطلاعات مرتبط را به صورت مفهومی ارائه دهند.

با این حال، هنگامی که می خواهید LLM ها محاسبات را به طور خودکار انجام دهند (مثلاً ضرب دو ماتریس واقعی)، ممکن است دقت آنها کاهش یابد. این اغلب به دلیل محدودیت ها و مشکلات درک متن و ساختار داده های ریاضی توسط این مدل ها است. آنها ممکن است ابعاد نادرست را محاسبه کنند یا در فرآیند محاسبه اشتباه کنند.

بنابراین، اگر قصد دارید از LLM برای کمک به شما در ریاضیات استفاده کنید، بهتر است از آنها برای درک مفاهیم نظری و فرآیندهای حل مسئله استفاده کنید. اما برای محاسبات واقعی و دقیق بهتر است خودتان آنها را انجام دهید یا از ابزارهای محاسباتی مخصوص استفاده کنید.

حتی اگر پاسخ در مجموعه داده های آموزشی مدل باشد، همیشه احتمال خطا وجود دارد. در نهایت، یادگیری و انجام محاسبات خود بهترین روش برای دقت و درک عمیق تر است.

چرا مدل های زبان بزرگ در ریاضیات ضعیف هستند؟ اولین بار در Tech Knock – اخبار دنیای فناوری. ظاهر شد.

گفتگو در مورد این post