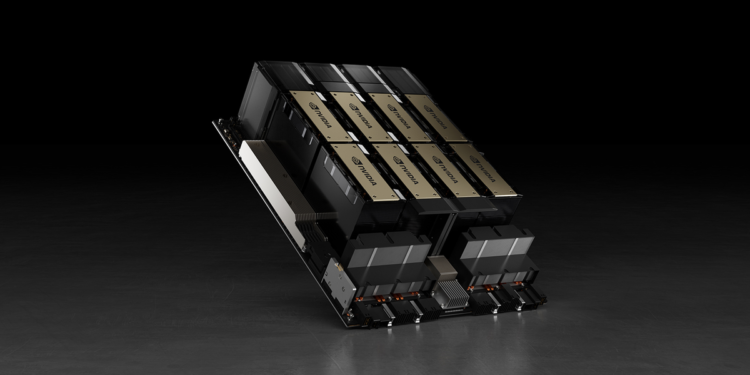

انویدیا ادعا می کند که پردازنده گرافیکی Nvidia H100 دو برابر سریعتر از MI300X AMD است و AMD از نرم افزار بهینه سازی شده برای دستگاه DGX H100 استفاده نکرده است.

به گزارش TechNock، در رونمایی Instinct MI300X، AMD ادعا کرد که آخرین GPU آن برای هوش مصنوعی (AI) و محاسبات با عملکرد بالا (HPC) به طور قابل توجهی سریعتر از GPU H100 Nvidia در دانلودهای استنباطی است. با این حال، هفته گذشته انویدیا نشان داد که وضعیت کاملا برعکس است. این شرکت ادعا می کند که با بهینه سازی مناسب، سرورهای مبتنی بر H100 سریعتر از سرورهای Instinct MI300X هستند.

تمژاردور این گزارش گزارش می دهد که انویدیا ادعا می کند که AMD از نرم افزار بهینه سازی شده برای دستگاه DGX H100 استفاده نکرده است که برای مقایسه عملکرد آن با سرور مبتنی بر Instinct MI300X استفاده شده است. شرکت فوق اشاره می کند که عملکرد بهینه هوش مصنوعی به یک چارچوب محاسباتی موازی قوی، مجموعه ای از ابزارهای همه کاره، الگوریتم های بسیار به روز و سخت افزار عالی بستگی دارد. به گفته انویدیا، بدون هیچ یک از این شاخص ها، عملکرد ضعیف خواهد بود.

انویدیا اضافه می کند که ویژگی های TensorRT-LLM شامل بهینه سازی های پیشرفته در سطح هسته برای معماری Hopper است که برای عملکرد H100 و پردازنده های گرافیکی مشابه بسیار مهم است. این تنظیم دقیق، اجرای عملیات شتابدهی FP8 را بر روی پردازندههای گرافیکی H100 با مدلهایی مانند Llama 2 70B بدون کاهش دقت استنتاجها ممکن میسازد.

برای اثبات این موضوع، انویدیا معیارهای عملکردی را برای سرور DGX H100 با 8 پردازنده گرافیکی H100 ارائه کرد که از مدل Llama 2 70B استفاده میکنند. DGX H100 میتواند کار استنتاج را تنها در 1.7 ثانیه با اندازه دستهای انجام دهد.

این بدان معناست که هر درخواست را به طور همزمان پردازش می کند، که کمتر از دستگاه هشت هسته ای MI300X AMD با زمان 2.5 ثانیه (بر اساس اعداد منتشر شده AMD) است. این تنظیم سریع ترین پاسخ را برای پردازش مدل ارائه می دهد.

به طور کلی، به منظور متعادل کردن زمان پاسخگویی و عملکرد کلی، سرویس های ابری اغلب از زمان پاسخگویی استاندارد برای برخی کارها (مانند 2.0، 2.3 و 2.5 ثانیه در نمودار) استفاده می کنند. این رویکرد به آنها اجازه میدهد تا چندین درخواست استنتاج را بهطور همزمان در دستههای بزرگتر پردازش کنند و در نتیجه تعداد کل استنتاجها را در سرور در هر ثانیه افزایش دهند. این روش اندازهگیری عملکرد، که شامل زمانهای پاسخ خاص است، یک استاندارد رایج در معیارهای صنعتی مانند MLPerf است.

حتی پیشرفت های کوچک در زمان پاسخ می تواند تعداد استنباط هایی را که یک سرور می تواند به طور همزمان انجام دهد را به میزان زیادی افزایش دهد. به عنوان مثال، با زمان پاسخ مشخص شده 2.5 ثانیه، سرور octet DGX H100 می تواند بیش از 5 استنتاج Llama 2 70B در هر ثانیه انجام دهد. این افزایش قابل توجهی در مقایسه با پردازش کمتر از یک استنتاج در ثانیه با راه اندازی Batch-One است. با این حال، انویدیا اعدادی برای Instinct MI300X AMD در هنگام اندازهگیری عملکرد در این تنظیمات نداشت.

پردازنده گرافیکی H100 انویدیا دو برابر سریعتر از MI300X AMD است، اولین بار در TechNock – اخبار جهان فناوری. ظاهر شد.

گفتگو در مورد این post