در آپدیت جدید اپرا، امکان اجرای مدل بزرگ هوش مصنوعی (LLM) به صورت محلی بر روی رایانه برای کاربران فراهم شده است.

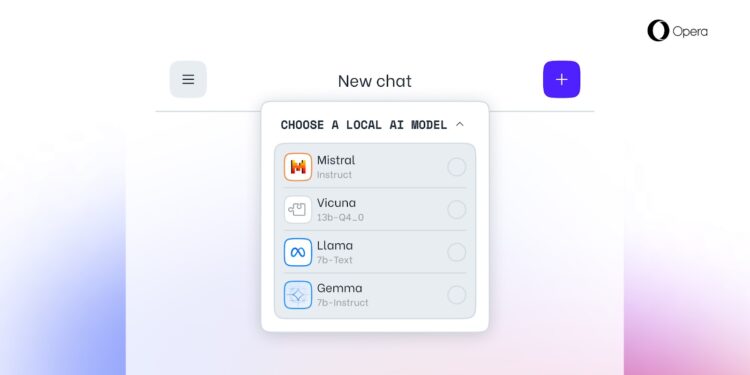

اپرا اعلام کرده است که کاربران می توانند مدل های زبان بزرگ (LLM) را به صورت محلی در رایانه خود دانلود و استفاده کنند. این ویژگی در ابتدا برای کاربران Opera One که بهروزرسانیهای جریان توسعهدهنده را نصب کردهاند در دسترس خواهد بود. با استفاده از این ویژگی، کاربران می توانند به بیش از 150 مدل زبان از بیش از 50 خانواده دسترسی داشته باشند.

مدل های زبانی که Opera One استفاده خواهد کرد عبارتند از Meta's Llama، Google's Gemma و Vicuna. این ویژگی بخشی از برنامه های Opera برای استفاده کاربران از سیستم های هوش مصنوعی است.

به گفته اپرا، چارچوب متن باز Ollama در مرورگر برای اجرای این مدل ها بر روی کامپیوتر استفاده می شود. در حال حاضر، تمام مدلهای موجود زیرمجموعهای از کتابخانه Ollama هستند، اما این شرکت قصد دارد مدلهایی را از منابع مختلف در آینده اضافه کند.

به گفته اپرا، هر نسخه از این مدل ها بیش از 2 گیگابایت فضای سیستم را اشغال می کند. بنابراین باید مراقب فضای خالی خود باشید تا فضای ذخیره سازی شما تمام نشود. لازم به ذکر است که اپرا هیچ برنامه ای برای اضافه کردن قابلیت ذخیره فضای ذخیره سازی در حین دانلود یک مدل ندارد.

جان استندال، معاون اپرا به TechCrunch گفت:

برای اولین بار، اپرا دسترسی به مجموعه عظیمی از LLMهای محلی شخص ثالث را مستقیماً در مرورگر فراهم کرده است. انتظار می رود که اندازه آنها با تخصصی تر شدن آنها در حل وظایف مورد نظر کاهش یابد.

اگر می خواهید از مدل های مختلف به صورت محلی استفاده کنید، این ویژگی می تواند خبرجو باشد. اما اگر صرفه جویی در فضا برای شما اولویت است، می توانید از ابزارهای آنلاین موجود مانند Quora's Poe و HuggingChat استفاده کنید.

اپرا از سال گذشته قابلیت های هوش مصنوعی را در سیستم های خود پیاده سازی کرده است. این شرکت در ماه می گذشته دستیار صوتی به نام آریا را در نوار کناری خود راه اندازی کرد و در ماه آگوست آن را به نسخه iOS اضافه کرد. در ژانویه، اپرا اعلام کرد که به دنبال ساخت یک مرورگر مبتنی بر هوش مصنوعی با موتور خود برای iOS است، زیرا قوانین بازار دیجیتال اتحادیه اروپا (DMA) اپل را ملزم میکند که الزامات موتور WebKit را برای مرورگرهای تلفن همراه کنار بگذارد.

گفتگو در مورد این post