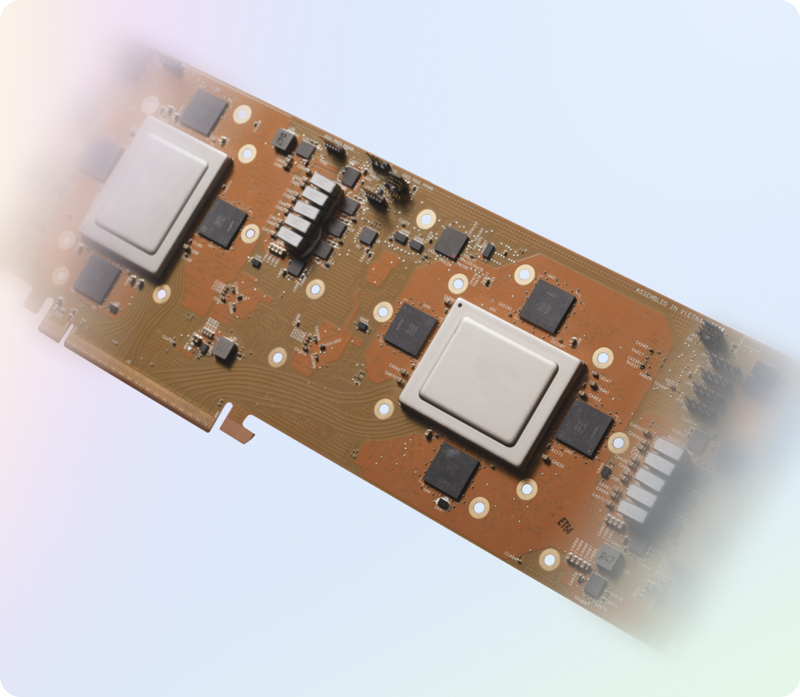

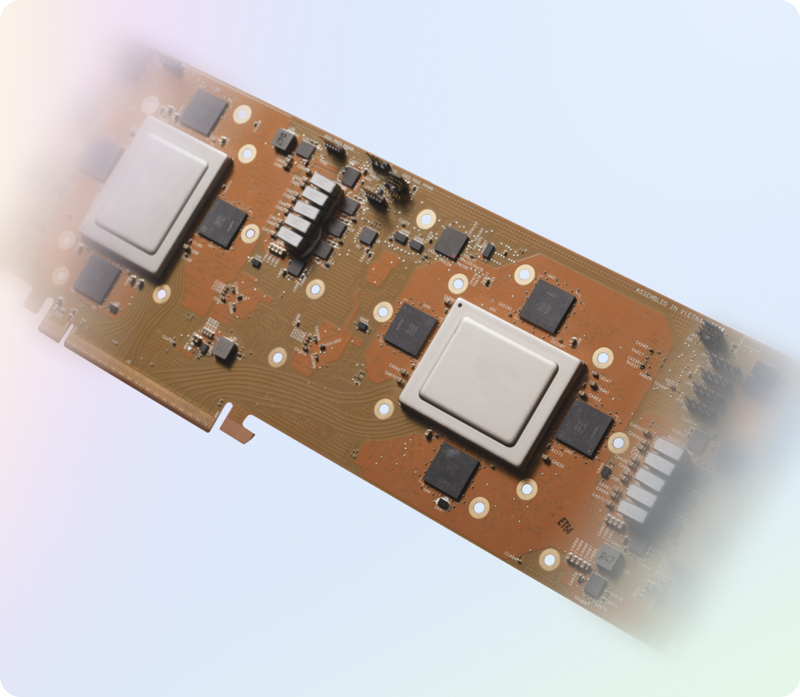

متا از تراشه هوش مصنوعی سفارشی جدیدی به نام «نسل بعدی MTIA» رونمایی کرده است که MTIA v1 نام دارد و برای اجرا و آموزش مدل های هوش مصنوعی طراحی شده است.

گزارش کردن تکناک، متا که مصمم به رقابت با رقبای خود در فضای مولد هوش مصنوعی است، میلیاردها دلار برای تلاش های هوش مصنوعی خود هزینه می کند. بخشی از این میلیاردها صرف جذب محققان هوش مصنوعی می شود. اما بخش بزرگتری به توسعه سختافزار اختصاص مییابد، بهویژه تراشههایی برای اجرا و آموزش مدلهای متا هوش مصنوعی.

این اطلاعیه یک روز پس از رونمایی از جدیدترین سخت افزار شتاب دهنده هوش مصنوعی توسط اینتل منتشر شد. این تراشه که “نسل بعدی” Meta Training and Inference Accelerator (MTIA) نامیده می شود، جانشین نسخه MTIA v1 سال گذشته است و مدل هایی را برای رتبه بندی و توصیه تبلیغات نمایشی در خدمات متا (مثلا فیس بوک) اجرا می کند.

در مقایسه با MTIA v1 که با فرآیند 7 نانومتری ساخته شد، نسل بعدی MTIA 5 نانومتری است. (در تولید تراشه، “فرآیند” به کوچکترین اندازه مولفه ای که می تواند بر روی یک تراشه ساخته شود اشاره دارد.) نسل بعدی MTIA از نظر فیزیکی بزرگتر است و هسته های پردازشی بیشتری نسبت به نسل قبلی خود دارد.

در حالی که این تراشه انرژی بیشتری مصرف می کند (90 وات در مقابل 25 وات)، همچنین حافظه داخلی بیشتری دارد (128 مگابایت در مقابل 64 مگابایت) و با سرعت متوسط کلاک بالاتر (1.35 گیگاهرتز در مقابل 800 مگاهرتز) کار می کند.

متا می گوید که نسل بعدی MTIA در حال حاضر در 16 منطقه از مراکز داده آنها فعال است و عملکردی تا 3 برابر بهتر از MTIA v1 ارائه می دهد. اگر ادعای “3x” کمی مبهم به نظر می رسد، اشتباه نمی کنید – ما نیز چنین فکر می کردیم. اما متا فقط فاش کرد که این رقم از آزمایش عملکرد “چهار مدل کلیدی” در هر دو تراشه به دست آمده است.

متا در یک پست وبلاگی نوشت: «از آنجایی که ما کل پشته را کنترل میکنیم، میتوانیم عملکرد بیشتری نسبت به GPUهای تجاری موجود داشته باشیم.

رونمایی از سخت افزار متا – که تنها 24 ساعت پس از یک کنفرانس مطبوعاتی در مورد ابتکارات مولد هوش مصنوعی این شرکت در حال انجام است – به چند دلیل غیرعادی است.

متا همچنین در پست وبلاگ خود فاش کرد که در حال حاضر از نسل بعدی MTIA برای کار آموزشی سازنده هوش مصنوعی استفاده نمی کند، اگرچه این شرکت ادعا می کند که “چندین برنامه در حال انجام” برای بررسی این موضوع دارد.

متا اعتراف کرد که نسل بعدی MTIA جایگزین پردازندههای گرافیکی برای مدلهای در حال اجرا یا آموزشی نمیشود، بلکه آنها را تکمیل میکند.

تیمهای هوش مصنوعی متا تقریباً برای کاهش هزینهها تحت فشار هستند. تا پایان سال 2024، این شرکت قصد دارد حدود 18 میلیارد دلار برای پردازندههای گرافیکی برای آموزش و اجرای مدلهای هوش مصنوعی مولد هزینه کند. از آنجایی که هزینههای آموزشی برای مدلهای تولیدی پیشرفته دهها میلیون دلار است، سختافزار داخلی جایگزین جذابی به نظر میرسد.

در حالی که سخت افزار متا عقب مانده است، رقبای آن در حال پیشروی هستند که احتمالاً باعث ناراحتی رهبری متا شده است. گوگل این هفته تراشه سفارشی نسل پنجم خود را برای آموزش مدلهای هوش مصنوعی، TPU v5p، برای مشتریان Google Cloud منتشر کرد و اولین تراشه اختصاصی خود را برای مدلهای در حال اجرا، Axion معرفی کرد.

آمازون چندین خانواده از تراشه های هوش مصنوعی سفارشی دارد. مایکروسافت نیز سال گذشته با شتاب دهنده هوش مصنوعی Azure Maia و CPU Azure Cobalt 100 وارد این رقابت شد.

متا در وبلاگ خود میگوید که کمتر از نه ماه طول کشید تا «از اولین مدلهای سیلیکونی به تولید مدلهای» نسل بعدی MTIA برود، که، انصافاً، کوتاهتر از زمان معمول بین TPUهای Google است. اما اگر متا امیدوار است به سطحی از اتکا به پردازندههای گرافیکی شخص ثالث دست یابد و با رقبای سخت خود مطابقت داشته باشد، کارهای زیادی برای انجام دادن دارد.

گفتگو در مورد این post